📢 Já ouviu falar na Arquitetura MoE? A Mixture Of Experts (MoE) é uma arquitetura utilizada em GenAI para criar modelos que, de maneira simplificada, são um “conjunto de modelos especialistas” e isto possibilita a diminuição na complexidade de treinamento do modelo e também sua escalabilidade operacional.

🧑💼 Uma maneira didática de separar um modelo MoE (ex.: Alibaba Qwen 2.5 Max, DeepSeek V3) de um modelo Denso (OpenAI 4o, o1) é a seguinte: os modelos Densos são como uma pessoa muito inteligente que sabe sobre muitos assuntos, já um MoE é como um time de especialistas onde cada um sabe apenas sua parte.

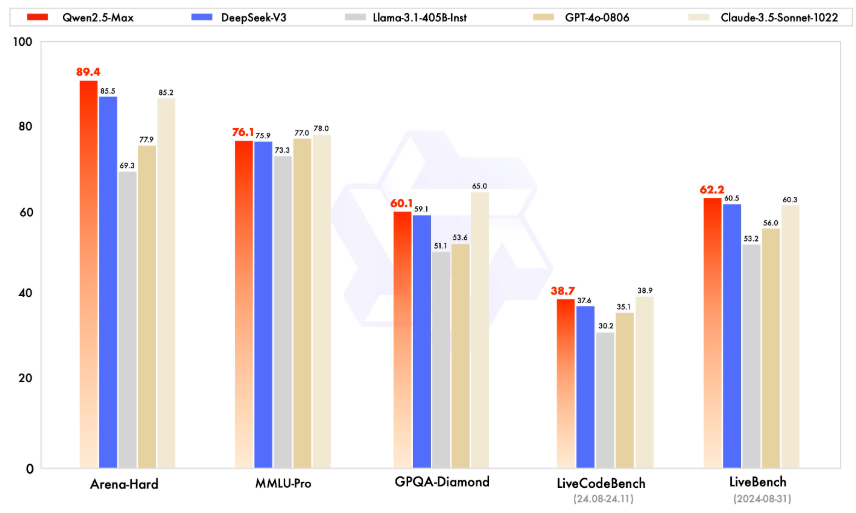

⚙️ Do ponto de vista operacional é mais fácil treinar e executar um MoE pois você pode treinar, adicionar ou executar partes específicas do modelo, sem precisar ativar o modelo como um todo e daí vem o grande ganho de escala em comparação aos modelos Densos. Do ponto de vista prático, estes modelos tem conseguidos resultados extraordinários contra seus concorrentes. Veja na imagem a comparação entre eles

Alibaba Qwen 2.5 Max