Utilizamos Inteligência Artificial para resolver problemas e explorar oportunidades

Data Visualization

Construção de dashboards e relatórios em ferramentas como o PowerBI

Nossa crença é de que as organizações podem ser mais analíticas, eficazes e eficientes através do uso da Inteligência Analítica. Seja utilizando a Análise de Dados Descritiva, Diagnóstica, Preditiva ou Prescritiva, nós temos a solução para sua empresa.

Utilizamos Inteligência Artificial para resolver problemas e explorar oportunidades

Construção de dashboards e relatórios em ferramentas como o PowerBI

Analisamos a saúde do seu Servidor de Banco de Dados e itens da LGPD

Precisa transformar seus dados em métricas de negócio? Nós podemos ajudar

Um estudo recente, conduzido pela FGV Ibre, adaptou uma metodologia internacional da Organização Internacional do Trabalho (OIT) e chegou a um dado que merece nossa total atenção: cerca de um terço dos trabalhadores brasileiros já está em ocupações expostas ao impacto da Inteligência Artificial.

Mas essa média esconde realidades muito distintas.

Quando olhamos setor a setor, o contraste é evidente: No Agro, o impacto estimado é de apenas 1,5%. Já no extremo oposto, o setor de Intermediação Financeira pode chegar a 90,6% de impacto potencial.

Entre esses dois polos, vemos números igualmente expressivos:

📊 Administração Pública (27,3%)

📊 Comércio (59,5%)

📊 Serviços de Informação (80,8%), entre outros.

Esses dados não falam apenas de tecnologia.

Eles falam de estratégia, preparo e escolhas.

👉 Do ponto de vista das empresas, a pergunta não é se a IA vai impactar seus produtos e processos, mas como fazer isso de forma consciente, responsável e competitiva. Mapear processos, redesenhar fluxos e capturar ganhos reais de eficiência exige método, visão sistêmica e experiência prática.

👉 Do ponto de vista dos profissionais, a transformação é ainda mais direta: quem aprende a trabalhar com IA amplia seu valor; quem ignora, corre o risco de ficar para trás. Não se trata de substituir pessoas, mas de aumentar capacidades humanas.

É exatamente nesse ponto que a Máquina de Dados atua.

Estamos aqui para conectar estratégia, dados e inteligência artificial, apoiando empresas e profissionais em jornadas reais de upskilling e reskilling na Era da IA.

👉 O futuro do trabalho não é um evento distante. Ele já começou.

A pergunta que fica é simples — e profundamente humana:

Você vai apenas assistir a essa transformação ou vai fazer parte dela?

Com duas décadas de experiência em Dados & Inteligência Artificial, e atuação em projetos estratégicos com organizações como Globo, Claro e Johnson & Johnson, desenvolvi um portfólio de palestras e workshops voltados à formação de lideranças preparadas para a Era da IA.

As empresas que desejam fortalecer sua cultura analítica e digital em 2026 encontrarão neste portfólio temas que unem estratégia, tecnologia e comportamento organizacional, como:

☑️ Fronteiras da Inovação: política, geopolítica e o impacto da IA nos negócios

☑️ Cultura Data-Driven na Era da GenAI

☑️ Letramento Analítico para Líderes AI First

☑️ A Era da Experimentação: Inovação, Prototipagem e Aprendizado Contínuo potencializados por IA

☑️ AI Leadership Experience: Jornada imersiva de um dia para líderes do futuro

Os conteúdos são modulares e podem ser aplicados em convenções de liderança, programas corporativos e semanas de inovação.

📘 Confira o portfólio completo abaixo

📩 Contato para empresas e RHs: felipe.pereira@maquinadedados.com.br

🏬 O memo do CEO da Shopify vai dar o que falar nas próximas semanas. Concordo com a filosofia e acho que aponta um caminho a ser seguido.

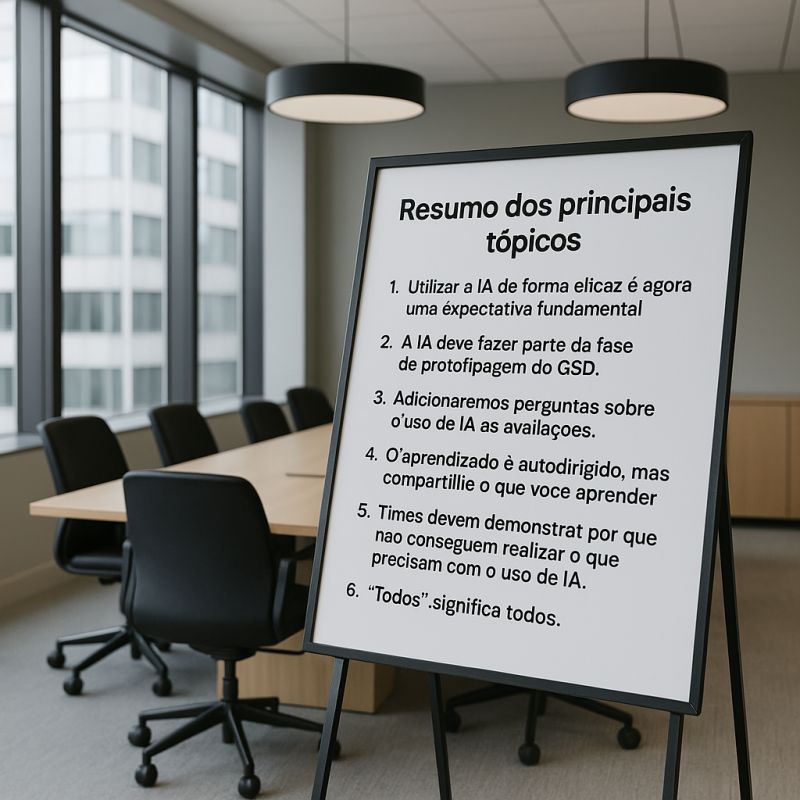

Seguem os pontos principais do memo:

1. Utilizar a IA de forma eficaz é agora uma expectativa fundamental para todos na Shopify. Hoje, ela é uma ferramenta para todas as áreas e só vai se tornar mais importante. Francamente, não acho viável optar por não aprender a aplicar IA na sua área de atuação; você pode tentar, mas quero ser honesto: não vejo isso funcionando hoje, e com certeza não funcionará no futuro. A estagnação é quase certa — e estagnação é um fracasso em câmera lenta. Se você não está subindo, está escorregando.

2. A IA deve fazer parte da fase de prototipagem do GSD. A fase de protótipo de qualquer projeto GSD deve ser dominada pela exploração com IA. Prototipar serve para aprender e gerar informação. A IA acelera esse processo de forma dramática. Você pode aprender a produzir algo que outros colegas consigam analisar, utilizar e compreender em uma fração do tempo que costumava levar.

3. Adicionaremos perguntas sobre o uso de IA aos nossos questionários de avaliação de desempenho e revisão entre pares. Aprender a usar IA bem é uma habilidade nada óbvia. Minha percepção é que muitas pessoas desistem após escrever um prompt e não receber exatamente o que esperavam. Aprender a criar prompts e carregar o contexto corretamente é importante, e obter feedback dos colegas sobre como isso está indo será valioso.

4. O aprendizado é autodirigido, mas compartilhe o que você aprender. Você tem acesso ao máximo de ferramentas de IA de ponta possível. Temos o chat.shopify.io há anos. Desenvolvedores têm acesso ao Proxy, Copilot, Cursor, Claude Code — tudo pré-configurado e pronto para uso. Vamos aprender e nos adaptar juntos, como um time. Vamos compartilhar conquistas (e tropeços!) uns com os outros enquanto experimentamos novas capacidades de IA, e vamos dedicar tempo para integração da IA nas nossas análises mensais de negócios e ciclos de desenvolvimento de produto. O Slack e o Vault têm muitos espaços onde as pessoas compartilham os prompts que criaram, como os canais #revenue-ai-use-cases e #ai-centaurs.

5. Antes de solicitar mais pessoas ou recursos, os times devem demonstrar por que não conseguem realizar o que precisam com o uso de IA. Como seria essa área se agentes autônomos de IA já fizessem parte da equipe? Essa pergunta pode levar a discussões e projetos muito interessantes.

6. “Todos” significa todos. Isso se aplica a todos nós — incluindo a mim e à equipe executiva.